本文原载《中文信息学报》2020年第1期,系四川大学“智慧法治”超前部署学科系列学术成果。本文契合司法人工智能的发展方向,提出以自然语言处理(NLP)为核心技术的司法案件案情知识图谱自动构建技术,对类案精准推送等司法人工智能应用提供语义支撑。

摘 要:以法学知识为中心的认知智能是当前司法人工智能发展的重要方向。该文提出了以自然语言处理(NLP)为核心技术的司法案件案情知识图谱自动构建技术。以预训练模型为基础,对涉及的实体识别和关系抽取这两个NLP基本任务进行了模型研究与设计。针对实体识别任务,对比研究了两种基于预训练的实体识别模型;针对关系抽取任务,该文提出融合平移嵌入的多任务联合的语义关系抽取模型,同时获得了结合上下文的案情知识表示学习。在“机动车交通事故责任纠纷”案由下,和基准模型相比,实体识别的F1值可提升0.36关系抽取的F1值提升高达2.37。以此为基础,该文设计了司法案件的案情知识图谱自动构建流程,实现了对数十万份判决书案情知识图谱的自动构建,为类案精准推送等司法人工智能应用提供语义支撑。

在人工智能推动下的司法改革当中,面向海量的裁判文书资源库,让机器通过一定的前沿技术认知案件,是当前人工智能司法应用的前提和薄弱之处。实现机器自动学习与认知案件将会对相似案例检索、类案精准推送、裁判文书自动生成等一系列司法应用产生重要影响。当前以连接主义代表性的深度学习技术、以符号主义代表性的知识图谱技术正在得到广泛而深刻的研究,这将会对各个行业领域带来深远的影响和变革。为此,我们以深度学习作为驱动技术,以知识图谱作为知识载体,实现面向司法案件的案情知识图谱自动构建,以实现机器对案件的认知。知识图谱的概念由谷歌公司于2012年正式提出,谷歌以此技术为基础构建下一代智能化搜索引擎。目前具有代表性的大规模知识库包括:Freebase[1]、Wikidata[2]、DBpedia[3]、YAGO[4]、Zhishi. me[5]、CN-DBpedia[6]等,其中后两个属于专门的中文知识库。上述知识库数据基本都来源于开放社区或开放域的数据,属于通用知识图谱,对实际垂直领域应用的意义并不大。随着知识图谱研究热潮的兴起,领域知识图谱的研究也逐渐得到重视,例如,目前两个大型开放学术知识图谱OAG[7]和AceKG[8],将有益于对学术数据挖掘的研究和开发。此外,医疗、金融等领域也可见到知识图谱的构建及应用之处。目前,面向垂直领域的知识图谱,数据来源主要是(类)结构化的文本数据,面向非结构化文本的知识图谱构建研究得并不广泛。对于垂直领域的非结构化文本,采用开放信息抽取的方法并不可行。为此,我们设计了有监督的实体识别—关系抽取串联的管道模型。针对实体识别任务,目前有效的手段还是基于深度学习的方法,此前主流的方法可分为基于循环神经网络RNN的方法[9-10](如:LSTMCRF),基于卷积神经网络CNN的方法[11](如:IDCNN)及混合模型的方法[12-13](如:LSTM-CNNCRF)。针对关系抽取任务,此前有效且主流的方法仍可分为基于RNN的方法[14-15]、基于CNN的方法[16-18]及其混合模型的方法[19]。上述任务一般都会利用Word2Vec[20]等词向量工具进行词向量表征,但是这种方式得到的词嵌入是静态的,法解决一词多义的问题,随着预训练模型研究的兴起,上述问题得到了解决。比较有代表性的模型包括:基于双层双向LSTM[21]的模型ELMo[22]、基于单向Transformer[23]的模型GPT[24]以及基于双向Transformer并融合下一句预测任务的模型BERT[25]。基于大规模文本进行无监督预训练可以充分学习其中蕴含的语义信息,通常都能直接提升现有的各项NLP任务。对于实体识别任务,谷歌的BERT-Softmax[25]模型超越以往的结果;对于关系抽取任务,采用预训练模型GPT并结合语言模型的多任务模型TRE[26]则达到了最好效果。司法裁判文书记载了人民法院的审理过程和结果,相比网络百科、新闻资讯文本,裁判文书的特点主要包括:文书制作的合法性,文本必须依法制作,这是基本前提;形式的程序性,表现在结构固定化和用语成文化;语言的精确性,表现在语义表达单一,准确精当。相比裁定书,由于判决书的数量占比大,案件事实与裁判说理记录更加详实,对于司法的技术研究更有价值。司法判决书主要包括类结构化的案件基本信息 和非结构化的文本。类结构化的案件基本信息反映了案件发生的主体,这也是案情事实的基础。非结构化文本类型主要包括案件当事各方的陈述、法院认定事实、法院说理及裁判结果这三种段落类型,案件当事各方的陈述虽描述了一定的客观事实,但由于都带有一定的主观性,可能会存在陈述矛盾的事实;法院说理及裁判结果集中在依据法律规范进行裁判主文的论证;法院认定事实,基于案件审理中举证质证情况,描述了影响案件裁判结果的事实。因此,以案件基本信息为基础,围绕法院认定事实文本进行案情知识图谱构建是非常有必要与合理的。本文以“机动车交通事故责任纠纷”案由下的司法判决书为研究对象,研究目标是为每一份文书自动构建形成一份案情知识图谱。本文的主要贡献如下:(1)我们对比研究了两种基于BERT的实体识别模型,实验表明解码输出层采用CRF可使得实体识别效果进一步提升了0.36。(2)我们提出了一种融合平移嵌入的多任务联合的语义关系抽取模型BERT-Multitask,相比基准模型,关系抽取结果F1值提升高达2.37。(3)我们设计了一个融合类结构化文本和非结构化文本的案件案情知识图谱自动构建流程,结果验证了该流程的可行性与有效性,并构建一个大规模司法案件的案情知识图谱,为类案精准推送等下游任务提供了语义支撑。实体在知识三元组中以节点的形式呈现,是构成知识图谱的主体和基础。图1展示了实体识别的基准模型。对于文本输入片段的token序列“[CLS]原告李家书[SEP]”,特殊标识符[CLS]和[SEP]用于标识句子序列的开始和结束,“李家书”作为一个自然人主体,采用BIO表示法,则对应的正确预测标签序列应为“OOOB-NPI-NPI-NPO”,其中NP代表自然人主体实体类别。

模型整体可划分为三大网络层,分别是输入嵌入层、特征抽取层以及解码输出层。输入嵌入层对输入的token序列进行向量空间的嵌入表示。每个token的空间嵌入表示组成包括对应的字符(词)嵌入、位置嵌入及句子嵌入、公式表示为Et =Ec+Ep+Es。其中,Et为该token的综合嵌入表示,Ec为该token的字符嵌入表示,Ep为该token所处位置的嵌入表示,Es为该token所处句子的嵌入表示。特征抽取层在token的向量空间嵌入的基础上实现更高层次的语义特征的抽取与表示,为每个token产生一个隐含状态Hi。在各项任务表现优秀的BERT预训练模型得益于Transfomer[23]模型的强大的特征抽取与编码能力。特征抽取层主要使用到Transfomer模型的6层的编码层,每个编码层主要由多头部注意力(multi-headattention[23])网络、前馈神经网络、残差网络(Residualnetwork[27])以及层标准化(layernormalization[28])模块组成。解码输出层实现对每个token的隐含状态进行标签预测。假设给定特征抽取层输出的隐含状态H及预测输出标签序列Y:

H经过线性投影,得到大小为(n+2×m的得分矩阵P,其中,(n+2)为输入序列的总长度,m为不同标签的数量,Pij对应该句中第i个token在第j个标签上的得分。对于输出得分矩阵P,应用Softmax得到该token预测标签的概率分布,取概率分布最大值所在的索引对应的标签作为预测标签。其中,第i个token在第j个标签上的概率计算如式(1)所示。

上述基准模型存在一个问题:上层解码预测输出层采用Softmax,序列的预测输出标签彼此独立,实际上,实体的输出标签序列前后存在一定的依赖关系。例如,输出标签I-MV只能跟随B-MV,而不能跟随标签B-NP,其中,MV代表机动车实体,NP代表自然人主体实体。因此,我们采用条件随机场(conditionalrandom field[29] ,CRF)作为解码输出层,以此来解决这个问题。图2展示了修正后的模型BERT-CRF,和基准模型的区别在于解码输出层的不同。结合上述特征抽取得到的隐含状态输出H,定义综合得分函数,如式(2)所示。

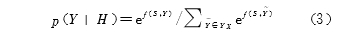

其中,A是输出标签之间的转移得分矩阵,其中,Aij对应标签i到标签j的得分。对输入隐含状态H的所有可能的输出标签序列应用Softmax,得到预测标签序列Y的概率,如式(3)所示。

我们需要使得综合得分最大化,一般取预测输出标签序列概率的对数,如式(4)所示。

其中,YX代表输入隐含状态对应所有可能的输出标签序列空间。根据上述公式,最大得分对应的输出标签序列即为最优的预测标签序列,如式(5)所示。

一般仅考虑任意两个标签之间的转移关系,上述最优解可以采用动态规划求得,我们采用维特比算法(Viterbialgorithm[30])进行解码。关系在知识三元组中以边的形式呈现,二元关系是一个三元组的语义核心。启发于GPT模型,引入语言模型作为辅助目标,可以提高模型泛化性能并加快收敛,我们引入知识三元组的平移嵌入(translatingembedding[31],TransE)任务作为辅助优化目标。图3展示了一种融合关系分类和平移嵌入两种任务联合的语义关系抽取模型 BERT-Multitask。对于给定的自然人主体类实体1“李家书”、人身损害赔偿项目类实体2“鉴定费”以及这两个实体出现的句子“原告李家书垫付了鉴定费”,目标是判断这两个实体存在预定义关系中的哪一类,结合上下文语境,正确的预测标签应为“遭受”关系类别。其中位于句子起始的特殊标识符[CLS]用于对整个句子做表征,这里不再需要对句子末尾进行标识。

这里的输入嵌入层与BERT特征抽取层和1.1节中实体识别任务中介绍的基本一致。对于输入的每个token,进行初始嵌入和特征抽取得到更高层次、更加丰富语义信息的隐含状态H。

在得到隐含状态H的基础上,进一步地映射和处理得到句子的特征、实体1的特征以及实体2的特征,为下一步特征融合和多任务联合学习做准备。

对于句子特征的获取,取第一个token(即[CLS])的隐含状态H[CLS],输入Pooler层,即可得到句子的特征表示,如式(6)所示。

对于实体特征的获取,我们对组成一个实体的所有的token序列的隐含状态输出的平均值作为该实体的特征表示,如式(7)所示。

其中,N为该实体序列的长度,k为实体序列起始的位置索引。我们对句子特征、实体1特征、实体2特征进行连接,输入到前馈神经网络,进行特征融合,以获得融合特征Ffused,如式(8)所示。

其中,Wfused为权重参数,bfused为偏置参数。

对于关系分类任务,考虑到特定的关系一般只会发生在特定的两个实体类别之间,我们将实体1的类别特征、实体2的类别特征与上述得到的混合特征进行连接得到最终的特征Ffinal=Fent1_label⊕Fent2_label⊕Ffused,输入到输出层Softmax,以进行输出标签y的预测,如式(9)所示。

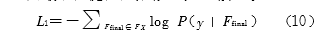

关系分类任务中,利用损失函数Cross Entropy Loss得到最小化优化目标,如式(10)所示。

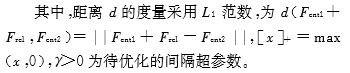

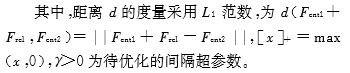

知识三元组平移嵌入模型TransE[31]的基本思想是:对于给定的知识三元组集合(h,r,t),由头实体和尾实体h,r∈E(实体集合)和一条关系r∈R(关系集合)组成,当(h,r,t)成立时,有h+r≈t,否则h+r与t相离应尽可能的远,使用d(h,r,t)来对它们之间的距离进行度量,可以采用L1范数或L2范数。对于一条训练数据,我们总有实体1、实体2、所在的句子以及对应的真实关系标签,考虑到这样得到的知识三元组都是证样例,为解决没有负样例的问题,我们从关系类别集合中随机选择一个非真实关系类别组成一条负样例。假定真关系标签的特征为Ftrue_rel,假关系标签的特征为Ffake_rel,采用损失函数Margin Ranking Loss得到平移嵌入任务的最小化优化目标,如式(11)所示。

综合考虑关系分类任务和知识三元组平移嵌入任务,得到综合损失函数,如式(12)所示。

我们以民事案由“机动车交通事故责任纠纷”一审判决书为研究对象,组织高校及相关司法企业的法律专家参与研究和讨论,并结合实际文书和现行的法律规范,对该案由涉及的实体和关系进行了预定义。最终,我们在该案由下预定义了20类实体类型(表1),考虑到违法行为种类过于繁多,而且大多数违法行为在文书中出现频次较低,我们选择了比较常见的9类违法行为,编号对应为12~20。

预定义的9种关系类型如表2所示,一个关系类型可能会对应多个实体类型对,例如,对于编号1的“驾驶”关系,就会存在(自然人主体驾驶机动车)和(自然人主体驾驶非机动车)这两条概念层知识三元组,合计可得到30条概念层知识三元组(这里不计“其他”关系类)。

考虑到中国东、中、西三大区域的经济及技术发展水平的差异,司法能力水平和文书写作规范也会存在一些区别。我们在东部选取“江苏省”和“浙江省”,中部选取“河南省”和“湖北省”,西部选取“四川省”和“云南省”以解决地域差异性带来的影响。每个省份随机选取100份判决书,合计获取600份判决书作为研究的原始文书数据。对上述选取的原始判决书进行数据预处理。首先需要对文书进行段落类型标记,考虑到文书的结构规范性和用语成文化,我们采用基于规则的方法对文书的段落类型进行标记。本文知识图谱构建来源的文本段落类型包括“当事人信息”等类型的类结构化文本和“法院认定事实”类型的非结构化文本,我们随机选择500 篇判决书进行规则预标注并交由人工审核,评估得到基于规则的这两种文本类型的分段效果的F1值分别为99.85和90.34。基于提取的类结构化文本,我们利用基于规则的方法对涉及到的民事主体进行提取,以获取案件的基本信息及用于案情事实中的“原告”和“被告”的补全处理,并用于后续实体对齐。我们采用开源的标注工具BRAT[32]进行部署与配置,以实现多人在线进行实体和关系的标注,将法院认定的事实文本进行分句处理并导入标注系统,在线标注示例截图如图4所示。

经过人工标注及审核,去除长度过短及质量很差的案例,最终获得585份案例的法院认定事实标注文本。为避免句子层级划分数据影响客观评价,我们在案例层级进行数据集的划分,数据集划分情况如表3所示,实体任务和关系任务的数据量统计针对句子层级。在建立关系任务数据集时,对于不存在关系且在关系实体类型对定义内的两个实体,选择“其他”关系标签并以0.5的保留概率作为“负 样例”。

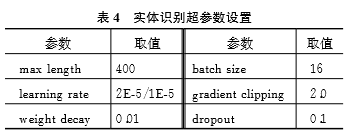

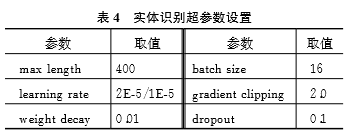

本实验环境在TeslaT4 16GB GPU环境下进行,使用PyTorch框架进行开发,在基本不损失精度的前提下,为了减少GPU的内存开销,加快训练速度,我们在程序设计中融入了一项称之为apex(https://github.com/NVIDIA/apex.)的混合精度训练(mixed precision training[33] )技术,BERT模型使用的是PyTorch的实现(https://github.com/huggingface/pytorch-pretrained-BERT.)(关系抽取任务与此一致)。表4展示了本实验涉及到的一些重要的超参数设置,主要是根据先前的工作及实际经验调试,并未进行严格的网格搜索。BERT-Softmax 和BERTCRF模型的参数除了初始学习率不一致,前者为2E-5,后者为1E-5,其余参数设置相同;句子的最大长度设为400,超过此长度的以标点切分两段处理;在权重参数添加系数为0.01的L2正则化项(偏置项不做处理),且在顶层的线性层的dropout[34]设置为0.1,以避免过拟合;小批量大小设为16;梯度裁剪的阈值设为2.0。

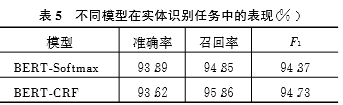

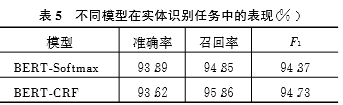

如表5所示,在测试集上,修正模型BERTCRF相比基准模型BERT-Softmax,准确率下降0.27,召回率上升1.01,综合指标F1有0.36的提升。综合来看,修正模型优于基准模型,表现出融入输出标签之间的转移约束关系可以使得实体识别的效果得到进一步提升。

基于较优的BERT-CRF模型,测试集上各实体类别的实体数量及对应F1值如图5所示,由于9类常见违法行为实体类别出现的数量均低于20,故不参与统计。统计结果表明:在实体数量大于等于20个的11类实体上,F1值在95以上的有6类,90以上的有7类,85以上的有8类,整体效果表现良好。但是对于非自然人主体、非机动车及财产损失赔偿项目实体类的表现较差。分析原因,首先这三类实体数量比较少,数据不足,导致模型学习不充分;死亡类实体数量虽然很少,但由于其表达如“死 亡”“致死”等比较固定,因而也能获得较好的效果;第二个原因在于实体表达的多样性,比如非机动车和财产损失赔偿项目表达的形式多种多样,例如,财产损失可能会涉及各种物品损失的表达,导致模型学习较为困难。

表6展示了关系抽取任务中一些重要的超参数设置,一些同名参数的意义和实体任务中参数介绍基本一致。特别地,实体标签的嵌入维度设为128,关系标签的嵌入维度设为768,平移嵌入任务的损失权重取值为1E-5,平移嵌入任务的间隔参数取默认值1.0。

参照SemEval-2010 Task 8[35]多关系分类任务的官方评测标准,我们取宏平均(macro-averaged)的准确率、召回率及F1值进行效果评估,唯一区别是学术研究标准任务评测未考虑“其他”关系类,考虑到模型要投入实际应用与更加客观的评价,我们将“其他”关系类别也一并考虑。实验表明,“其他”类关系抽取的表现往往要低于平均值。如表7所示,在测试集上,改进后的模型BERT-Multitask模型相比基准模型 BERT-Base,准确率、召回率及F1值都获得了全面提升,综合指标F1提升高达2.37,表明融入平移嵌入的多任务联合的语义关系抽取模型能够明显改善关系抽取的效果,验证了融入语义信息约束的有效性。在模型 BERT-Multitask训练完成后,利用该模型同时可以得到一件非常有价值的副产物,即一种结合了上下文及三元组语义关系的实体和关系的向量嵌入表示。

基于表现更好的BERT-Multitask模型,测试集上各个关系类别的数量及表现如图6所示。9类关系类别中,F1值在95以上的有4类,90以上的有6类,85以上的有7类,综合表现良好。负样例“其他”关系类的F1值为91.05,低于综合表现91.64。而对于“搭乘”和“发生事故”这两类关系,它们的抽取效果则要表现较差一些,经分析发现,涉及这两类关系的数据量相对较少,且这两类关系的两实体的相隔距离往往较远。

在“机动车交通事故责任纠纷”案由下,案情知识图谱构建的文本类型包括类结构化文本与非结构化文本。类结构化文本涉及的段落类型包括:“文 书标题”“案号”“受理法院”及“当事人信息”,非结构化文本只包含“法院认定事实”段落类型。司法案件的案情知识图谱自动构建流程图如图7 所示。

对于类结构化文本,我们采用基于规则的方法 进行抽取,以获取案情的基本信息;对于非结构化文本,我们采用基于深度学习的方法进行抽取,以获取案情关系知识三元组;对案件案情的基本信息和知识三元组进行知识融合,最终获得该案件的案情知识图谱。Step1 分段标记。给定一篇司法判决书Doc,采用基于规则的方法进行分段标记,识别出上述定义的类结构化文本Text1和非结构化案情事实文本Text2;Step2 类结构化信息抽取。基于规则对Text1进行抽取,获得“文书标题”“案号”“受理法院”作为“案件”实体的属性信息,从“当事人信息”类文本中抽取民事主体基本信息Info,涉及名称及其委托代理人信息等;Step3 数据预处理。对Text2进行文本预处理,涉及原被告的指代补全及分句处理等,获得句子列表List1;Step4 实体识别。基于训练的实体识别模型 BERT-CRF,对List1逐一进行实体识别,获得实体数据列表List2,每条数据包含:句子及实体(包含类别)的集合;Step5 关系抽取。对List2每一条数据所含实体在预定义关系实体对范围内进行组合,形成关系数据列表List3;每条数据包含:实体1及其类别,实体2及其类别,所在句子。利用学习的关系抽取模型BERT-Multitask对List3逐一进行关系抽取,最终获得案情事实三元组Triplets;Step6 识融合。由于关系类别是标准的预定义,融合主要实现Info和Triplets 的实体对齐。主要采用一些基于规则的方法。例如,利用两实体之间的固定表达制定规则,如“如下简称”“简写为”等类似表达;利用实体自身的特点,如“川A×××××号小轿车”与“川A×××××号”的实体类别和关系约束,可根据车牌号进行对齐。实体对齐处理后得到案情知识Knowledge;Step7 知识存储与可视化。将Knowledge写入Neo4j图数据库进行存储与可视化展示。对新输入的一份司法判决书,通过上述流程自动生成的案件案情知识图谱如图8所示,结果验证了该构建流程的可行性和有效性。根据该流程,我们在“机动车交通事故责任纠纷”案由下,选取了20万余份一审判决书进行了案情知识图谱自动构建,获得了一个大规模司法案件的案情知识图谱。

本文致力于面向司法案件的案情知识图谱自动构建的研究与实现。对于知识图谱构建涉及的两个重要的NLP任务进行了重点研究:针对实体识别任务,对比研究了两种基于BERT的实体识别模型,采用CRF进行解码输出可使结果得到进一步提高;针对关系抽取任务,我们提出了一种融合平移嵌入的多任务联合的语义关系抽取模型BERT-Multitask,明显改善了关系抽取的效果。最后,我们设计 了一个融合了类结构化文本和非结构化文本的案情知识图谱自动构建流程,通过实验对该流程的可行性和有效性进行了验证,并构建了一个大规模案件的案情知识图谱。本文研究的案情知识图谱自动构建的一个重要的前期工作是段落类型标记任务,目前采用基于规则的方法,非结构化案情事实文本的提取效果相对较差,下一步将结合一些监督学习的方法提升该任务的效果;为进一步提升与合理评价案情图谱构建质量,下一步将继续加大数据标注规模,算法与构建流程中也充分考虑法律知识并结合文书自身特点,并建立合理的案情知识图谱构建质量评价体系;围 绕已构建的大规模案件的案情知识图谱,进行类案精准推送与检索等司法应用的研究。

[1] Bollacker K, Evans C, Paritosh P, et al. Freebase: a collaboratively created graph database for structuring human knowledge[C]//Proceedings of the 2008 ACM SIGM OD International Conference on Management of Data,2008:1247-1250.[2] Vrandecic D, Krötzsch M. Wikidata:a free collaborative knowledge base[J] .Communications of the ACM, 2014,57(10):78-85.

[3] Bizer C, Lehmann J, Kobilarov G, et al. DBpedia-acrystallization point for the web of data [J]. Journal of Web Semantics, 2009, 7(3):154-165.

[4] Suchanek F M, Kasneci G, Weikum G. Yago: a core of semantic knowledge[C]//Proceedings of the 16th International Conference on World Wide Web, 2007:697-706.

[5] Niu X, Sun X, Wang H, et al. Zhishi. me-weaving Chinese linking open data [C]//Proceedings of the10th International Semantic Web Conference, 2011:205220.

[6] Xu B, Xu Y, Liang J, et al.CN-DBpedia: a neverending Chinese knowledge extraction system [C]//Proceedings of International Conference on Industrial, Engineering and Other Applications of Applied Intelligent Systems, 2017:428-438.

[7] Tang J, Zhang J, Yao L, et al. ArnetMiner: extraction and mining of academic social networks [C]//Proceedings of the 14th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 2008: 990-998.

[8] Wang R, Yan Y, Wang J, et al. AceKG: a large-scale knowledge graph for academic data mining[C]//Proceedings of the 27th ACM International Conference on Information and Knowledge Management, 2018:14871490.

[9] Huang Z, Xu W, Yu K. Bidirectional LSTM-CRF models for sequence tagging[J/OL]. arXiv preprint arXiv: 1508.01991, 2015 .

[10] Lample G, Ballesteros M, Subramanian S, et al. Neural architectures for named entity recognition [C]//Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, 2016:260-270.

[11] Strubell E, Verga P, Belanger D, etal. Fast and accurate entity recognition with iterated dilated convolutions[C]//Proceedings of the 2017 Conference on Empirical Methodsin Natural Language Processing, 2017:2670-2680.

[12] Ma X, Hovy E. End-to-end sequence labeling via bidirectional LSTM-CNNs-CRF [C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, 2016:1064-1074.

[13] Chiu JPC, Nichols E. Named entity recognition with bidirectional LSTM-CNNs[J]. Transactions of the Association for Computational Linguistics, 2016, 4:357-370.

[14] Zhang S, Zheng D, Hu X, et al. Bidirectional long short-term memory networks for relation classification[C]//Proceedings of the 29th Pacific Asia Conference on Language,2015:73-78.

[15] Zhou P,Shi W ,Tian J,et al. Attention-based bidirectional long short-term memory networks for relation classification[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, 2016:207-212.

[16] Zeng D, Liu K, Lai S, et al. Relation classification via convolutional deep neural network[C]//Proceedings of the 25th International Conference on Computational Linguistics: Technical Papers, 2014:23352344.

[17] Shen Y, Huang X. Attention-based convolutional neural network for semantic relation extraction[C]//Proceedings of the 26th International Conference on Computational Linguistics: Technical Papers, 2016:2526-2536.

[18] Wang L, Cao Z, De Melo G, et al. Relation classification via multi-level attention CNNs[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, 2016:1298-1307.

[19] Zhang X , Chen F, Huang R.A combination of RNN and CNN for attention-based relation classification [J] .Procedia Computer Science, 2018, 131:911917.

[20] Mikolov T , Sutskever I, Chen K, et al. Distributed representations of words and phrases and their compositionality[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems, 2013:3111-3119.

[21] Hochreiter S, Schmidhuber J. Long short-term memory[J] .Neural Computation, 1997,9(8):17351780.

[22] Peters M E, Neumann M, Iyyer M, et al. Deep contextualized word representations [C] //Proceedings of the2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, 2018:2227-2237.

[23] Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems, 2017:5998-6008.

[24] Radford A , Narasimhan K , Salimans T, et al. Improving language understanding by generative pretraining [J/OL]. 2018, https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/languageunsupervised/language_understanding_paper. pdf.

[25] Devlin J, Chang M W, Lee K, et al. BERT: pretraining of deep bidirectional transformers for language understanding [J].arXiv preprint arXiv:1810.04805,2018.

[26] Alt C, Hübner M, Hennig L. Improving relation extraction by pre-trained language representations[C]//Proceedings of the 2019 Conference on Automated Knowledge Base Construction,2019.

[27] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2016:770-778.

[28] BaJ L, Kiros JR, Hinton GE. Layer normalization [J] .arXiv preprint arXiv:1607. 06450,2016.

[29] Lafferty J, McCallum A, Pereira FCN. Conditional random fields: probabilistic models for segmenting and labeling sequence data[C]//Proceedings of the 18th International Conference on Machine Learning, 2001: 282-289.

[30] Forney GD .The viterbi algorithm [C]//Proceedings of the IEEE,1973, 61(3): 268-278.

[31] Bordes A, Usunier N, Garcia-Duran A, et al. Translating embeddings for modeling multi-relational data [C]//Proceedings of the 26th International Conference on Neural Information Processing Systems,2013:2787-2795.

[32] Stenetorp P , Pyysalo S, Topic G, et al. BRAT: a web-based tool for NLP-assisted text annotation [C]//Proceedings of the Demonstrationsatthe13th Conference of the European Chapter of the Association for Computational Linguistics, 2012: 102107.

[33] Micikevicius P, Narang S , Alben J, e tal. Mixed precision training[C]// Proceedings of International Conference on Learning Representations, 2017.

[34] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J] .Journal of Machine Learning Research,2014,15(1): 1929-1958.

[35] Hendrickx I, Kim SN, Kozareva Z, et al. Semeval2010 task8: multi-way classification of semantic relations between pairs of nominals[C]//Proceedings of the 5th International Workshop on Semantic Evaluation, 2010: 33-38.

![]()